Vývojářům došla data z internetu, musí použít umělá. Al se tak poprvé dozví i o vlastní existenci, popisuje odborník Koubský

Poslechněte si celý pořad Online Plus Davida Slížka.

Vývojářům generativních AI systémů docházejí data, která potřebují k trénování svých systému. Dosud všechny velké AI chatboty, jako je chatGPT, Google Bard nebo Claude, pracovaly s daty, které firmy stáhly z internetu. Šlo o konverzace na sociálních sítích, obsah Wikipedie a dalších encyklopedií, digitalizované knihy, texty z blogů a další zdroje.

Čtěte také

Většinu použitelných dat už použily, a navíc narážejí na stále hlasitější protesty jejich autorů a vlastníků. Proto se začínají obracet k synteticky vytvořeným údajům, které připravují specializované AI systémy.

O tématu psal podrobně deník The Financial Times. Tvůrci AI systémů teď podle něj potřebují hlavně specializovaná data z různých oborů. Pořídit si je od firem nebo si je nechat zpracovat lidskými autory, by vyšlo příliš draho.

Proto je nechávají generovat strojově. Data mohou vznikat například tak, že je vytvářejí dva AI systémy, které spolu „mluví“ o nějakém tématu, například o matematice. Lidský matematik pak jen zkontroluje, zda nebyly v konverzaci chyby. Na těchto datech se pak trénují další AI systémy.

Cesta nouze

Podle Petra Koubského, redaktora Deníku N, jde o postup, který by vývojáři nezvolili dobrovolně, a který bude mít spíše svá negativa než pozitiva.

Čtěte také

„Myslím si, že syntetická data mají hlavně nevýhody. Není to přirozený lidský jazyk, na kterém by se jazykové modely měly učit. Je tam veliké riziko, že kvalita bude klesat. To riziko je dobře známé, ale zejména copyrightové důvody vedou k tomu, že se k tomu musí přistupovat. Rozhodně to ale není řešení, které by si ti vývojáři zvolili dobrovolně. Jsou k němu dotlačeni, takže takové řešení z nouze,“ míní.

Internet není bezedný

Všechny velké jazykové modely se zatím učily na datech, která neobsahovala žádné zmínky o nich samých. Počítalo se s tím, že bude zajímavé, až se dozví, že existuje něco jako velký jazykový model.

Čtěte také

„Pokud se učí na něčem, co není přirozená lidská řeč, dá se to sice mírnit kontrolou, což ale zas naráží na kapacitní možnosti lidí, kteří s tím pracují. Myslím si, že v tuto chvíli je to velký problém, a ne kvůli tomu, že se modely dovědí o své vlastní existenci. V každém případě: Tohle by se modely učit neměly. Hodně chytrých lidí si teď velmi intenzivně láme hlavu, co s tím a jak nedostatek odstranit,“ říká.

The Financial Times také píše, že dnes už vývojáři potřebují hlavně specializovaná data z konkrétních úzce profilovaných vědních oborů, jako je matematika apod.

Jsou to informace, které nemohou nikde na internetu najít, a právě i proto používají syntetická data, která si nejdřív vloží do jednoho AI systému a ten pak konverzuje s druhým. Z toho vznikají data, která by normálně jinde neměli.

„Tohle se asi nedá udělat jinak. Věřme, že vědí, co dělají, ale je to méně dobrá situace, než kdyby měli obrovskou zásobárnu volně použitelných dát vytvořených lidmi,“ dodává.

Poslechněte si celý pořad Online Plus Davida Slížka v audiozáznamu. Dále se dozvíte o tom, proč herci bojkotují AI v jejich branži, o tom, jak eurokomisař hrozí sociálním sítím vypnutím, když nebudou včas mazat nezákonný obsah nebo jak Meta vypustila zdarma svůj velký jazykový model.

Mohlo by vás zajímat

Nejposlouchanější

Více z pořadu

E-shop Českého rozhlasu

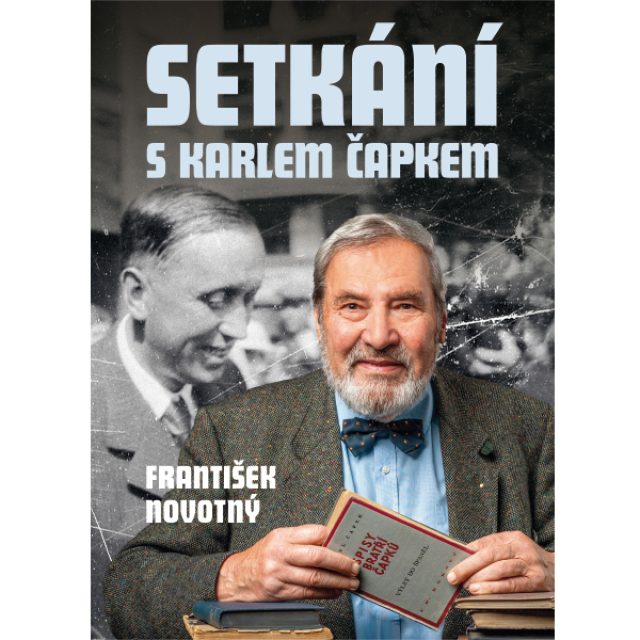

Přijměte pozvání na úsměvný doušek moudré člověčiny.

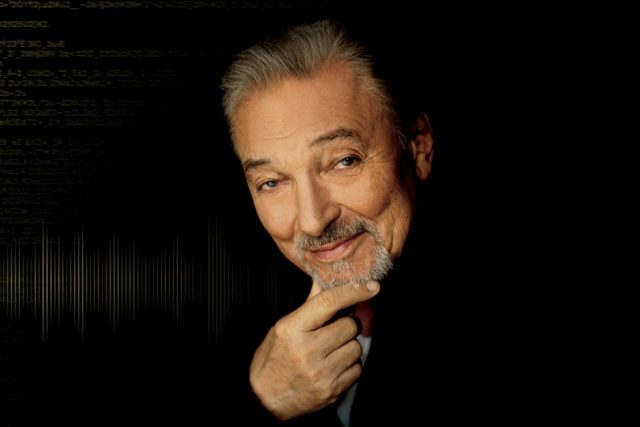

František Novotný, moderátor

Setkání s Karlem Čapkem

Literární fikce, pokus přiblížit literární nadsázkou spisovatele, filozofa, ale hlavně člověka Karla Čapka trochu jinou formou.