Jan Fingerland: Izraelci v Gaze nasadili umělou inteligenci. Je dost chytrá?

O umělé inteligenci se v souvislosti s válkou v Gaze zatím mluvilo především kvůli výrobě falešných obrazů z bojišť. Teď přibylo nové téma, totiž skutečnost, že izraelská armáda používá umělou inteligenci pro identifikaci cílů. I to je vlastně přelom, možná ještě epochálnější.

Umělou inteligenci v boji pravděpodobně použili už Rusové na Ukrajině při nasazení samostatně se rozhodujících dronů. Podobné zbraně vyvíjejí Američané i Číňané. Několik desítek zemí podepsalo deklaraci o zodpovědném používání umělé inteligence a autonomního rozhodování ve vojenství. Izraelci se svou aplikací AI přišli v roce 2019, a poprvé ve větším měřítku nasadili při střetnutí s Hamásem v Gaze v roce 2021.

Řízení střelby

V tomto případě šlo o výběr vojenských cílů pro střelbu. Podle izraelských tvrzení se tím množství cílů mnohonásobně zvětšilo a umožňuje pálit nejen intenzivněji, ale i přesněji.

Čtěte také

Systém Habsora pravděpodobně využívá schopnost rychle a ve velkých objemech kombinovat informace několika druhů, od pozorování dronů, přes různé databáze až po odposlechy.

Pravděpodobně také pracuje s informacemi získanými ze sledování pohybů a charakteristického jednání jednotlivců i celých skupin. Tak může zaměřit třeba ozbrojence, kteří dříve udeřili a pak rychle zmizeli v zástavbě, možná tedy systém rozpozná místa vstupů do tunelů, skladů nebo skrýší. O výsledky tohoto systému se nepochybně budou zajímat armády mnoha zemí. Současně už v těchto dnech vzbudil zájem mnoha novinářů.

V některých západních médiích se objevily kritické články, které se snaží izraelská tvrzení zpochybnit, obvykle na základě obecných úvah, odvolávání se na odborníky v příbuzných oblastech nebo výpovědích anonymních hlasů zevnitř izraelské armády.

Čtěte také

Proti užití Habsory zmiňují nejrůznější důvody. Například to, že umělá inteligence se může dopouštět omylů. Konkrétně v případě Habsory ale každý jí předvybraný cíl ještě podléhá dozoru živého vojáka. Proto se jiný typ kritiky zaměřuje odlišným směrem.

Například že izraelští vojáci prý nemají dost času na kvalitní ověřování a rozhodování; že někteří vojáci jsou méně uvážliví než jiní; že určování cílů nabývá příliš mechanické podoby; že náhlý nadbytek cílů vede ke střelbě na méně kvalitní cíle, třeba obydlí nižších kádrů Hamásu, a nikoli jen vyšších velitelů; anebo že systém počítá s tím, že při střelbě na konkrétní cíl zemře předem známé množství civilistů.

Zvěstování budoucnosti

Čtěte také

Jenže toto vše je pravda i o klasickém válčení, a nevyplývá z toho nic o tom, jak ho užívají konkrétně Izraelci a jak jsou nastaveny parametry používání Habsory. Přinejmenším teoreticky je možné, že výsledně je použití umělé inteligence pro civilisty méně ničivé, avšak ani to nikdo nemůže bezpečně tvrdit. Hodnocení Habsory tedy dost často záleží na naladění konkrétních mluvčích.

První velký text uveřejnil britský Guardian s pomocí izraelského webu +972, známého svým kritickým postojem k samotnému Izraeli. Článek se systematicky snaží vyvracet jakákoli oficiální izraelská tvrzení, ale žádný jednoznačný závěr nedělá. Řada dalších autorů sice stavěla na tomto textu, posunula jeho vyznění k větší kritičnosti. Například turecká agentura Anadolu zprávu uveřejnila pod titulkem „Izrael využívá umělou inteligenci k identifikaci potenciálních civilních cílů, aby maximalizoval počet palestinských obětí.“

Zajímavé je, že všechny tyto články přejímají mylný překlad hebrejského slova Habsora jako Gospel, tedy Evangelium. Správně to znamená Zvěstování, dotyční autoři možná neznají dost hebrejštinu, angličtinu, anebo Bibli, možná tedy ani umělou inteligenci. Zdá se, že nejen ve vojenství, ale i v žurnalistice se umělá inteligence ještě nějakou dobu neobejde bez té přírodní.

Autor je komentátor Českého rozhlasu

Nejposlouchanější

Více o tématu

E-shop Českého rozhlasu

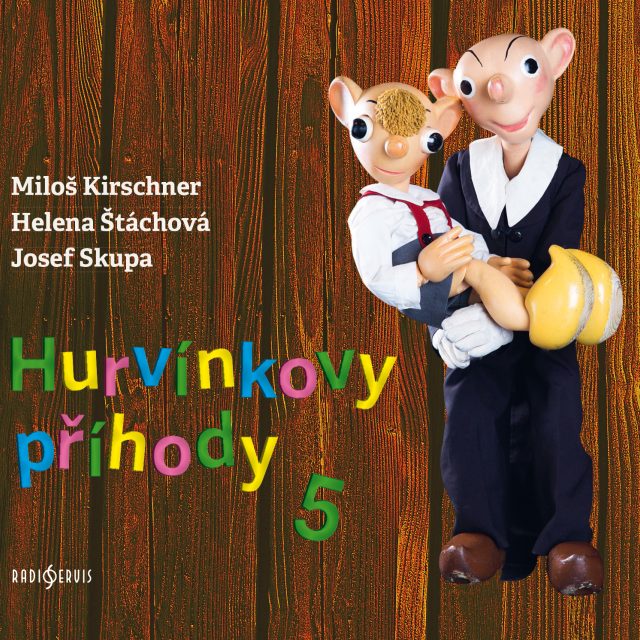

Hurvínek? A s poslední rozhlasovou nahrávkou Josefa Skupy? Teda taťuldo, to zírám...

Jan Kovařík, moderátor Českého rozhlasu Dvojka

Hurvínkovy příhody 5

„Raději malé uměníčko dobře, nežli velké špatně.“ Josef Skupa, zakladatel Divadla Spejbla a Hurvínka