Bylo by chybou zpomalit vývoj AI, Čína ji má jako závod, říká etik Černý. Lidstvo by se mělo domluvit na regulaci, míní matematik Kulveit

Tento týden se na Londýnském summitu v v Bletchley Parku představitelé EU a dalších 28 zemí shodli na první deklaraci, která má podpořit globální snahu o zajištění bezpečnosti umělé inteligence (AI). Podle slov britského premiéra Rishiho Sunaka mělo setkání převážit misky vah ve prospěch lidstva. Co je však předpokladem bezpečného vývoje umělé inteligence?

Jan Kulveit, vědec se z Centra pro teoretická studia Univerzity Karlovy, který se v současnosti soustředí na výzkum komplexních systémů složených z lidí a umělých inteligencí by ocenil, kdyby se lidstvo dokázalo na zbrzdění růstu modelů shodnout.

„Je to koordinační problém, na kterém pokud se neshodneme, je potřeba aspoň vývoj zkusit regulovat a posílit stranu zkoumání bezpečnosti modelů, o což se snažil i summit. Je možné, že to vývoj trochu zpomalí,“ dodává.

Čtěte také

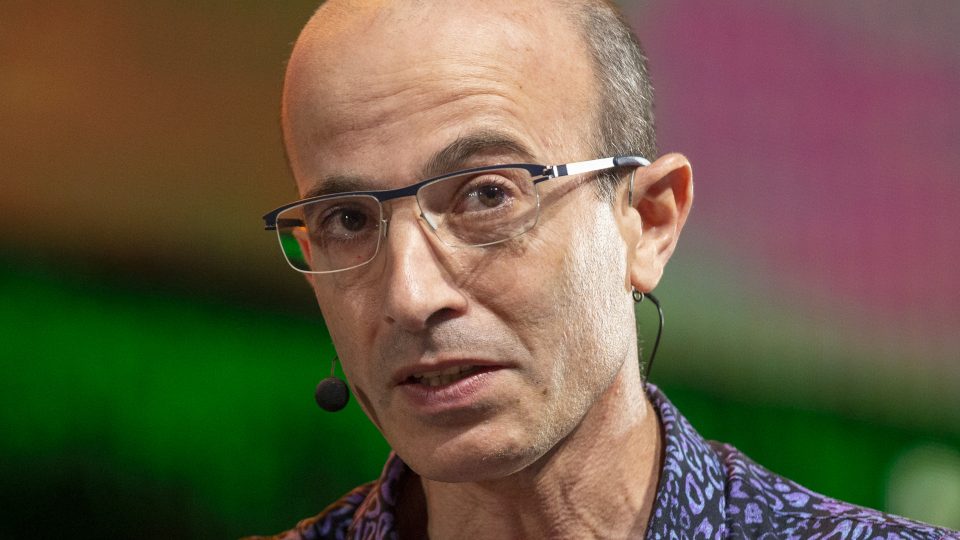

Filozof, který se zabývá etikou umělé inteligence David Černý a zároveň působí na Ústavu státu a práva a na ústavu informatiky Akademie věd, si nemyslí, že je taková domluva realistická.

„Z pohledu Evropy a našeho západního kulturního okruhu by bylo chybou, kdybychom si uložili nějaká zpomalování, protože systémy AI jsou klíčem jak ke generování blahobytu, tak k novým vědeckotechnickým objevům, a zároveň geopolitickým nástrojem dominance,“ namítá.

Držet krok s Čínou

Podle Černého jiné státy budou AI vyvíjet dál. „Čína chce ve vývoji předběhnout celý svět. Uvědomuje si, že to je klíč k budoucnosti blízké i vzdálenější. Nezbude nám nic jiného než se snažit s Čínou držet krok a nenechat ji, aby nás zásadně předběhla.“

Čína se summitu účastnila také a zavázala se ke spolupráci. „To, že tam byla ale neznamená, že bude dodržovat pravidla,“ domnívá se Černý. „AI musí být k dispozici jejich armádě, takže nevěřím, že by byla ochotna začít zásadním způsobem omezovat vývoj.“

Čtěte také

„Vývoj těch největších modelů neprobíhá v Evropě. To je otázka Západu, tedy Spojených států a Velké Británie. Navíc strašák, že když zpomalíte, tak nás Čína předběhne, se používá roky, ale neodpovídá realitě. Sama Čína má obavy, že AI destabilizuje její společnost – ještě před summitem podepsala separátní prohlášení, kde před riziky varuje,“ podotýká Kulveit.

Vhodná míra regulace

Rishi Sunak na summitu nabádal k tomu, aby se nespěchalo s tvrdou regulací AI, načež se ohradil indický ministr technologií se slovy, že pokud umožníme inovacím předběhnout regulaci, otevíráme se toxicitě, dezinformacím a zbrojení.

„Je potřeba najít mechanismy k identifikaci a odstraňování rizik nebo jejich minimalizaci. Zároveň si nejsem jistý, zda regulace neubíjí potenciál vývoje AI v České republice,“ říká Černý. Dodává, že lidé hledí na regulace spíše s obavami, aby nám tzv. neujel vlak.

Čtěte také

„Je třeba najít šikovnou míru dostatečné regulace, aby vývoj mohl probíhat dál, abychom byli konkurenceschopní a zároveň neregulovat příliš, aby se ten vývoj nezpomalil. AI sama o sobě rizikem není, rizikové je to, jakým způsobem a pro jaké účely ji lidé používají. Nejlepším způsobem ochrany proti negativním důsledkům je vzdělávání lidí, aby získali algoritmickou gramotnost,“ tvrdí.

„Tato technologie je méně regulovaná, než když si chcete otevřít zmrzlinářství, přičemž je strategicky důležitější než jaderné zbraně či letectví,“ míní Kulveit.

„Souhlasím, že je potřeba vzdělávat veřejnost, ale těch rizik je mnohem víc. Včera se přední laboratoře shodly s Evropskou unií, Spojenými státy a Británií na tom, že modely budou podléhat nezávislému testování instituty a myslím, že v tom by Evropa neměla zůstat pozadu a také vytvořit vlastní ústav, nezávislou autoritu, která dokáže modely testovat,“ dodává.

Poslechněte si celou diskusi v audiozáznamu. Moderuje Karolína Koubová.

Mohlo by vás zajímat

Nejposlouchanější

Více z pořadu

E-shop Českého rozhlasu

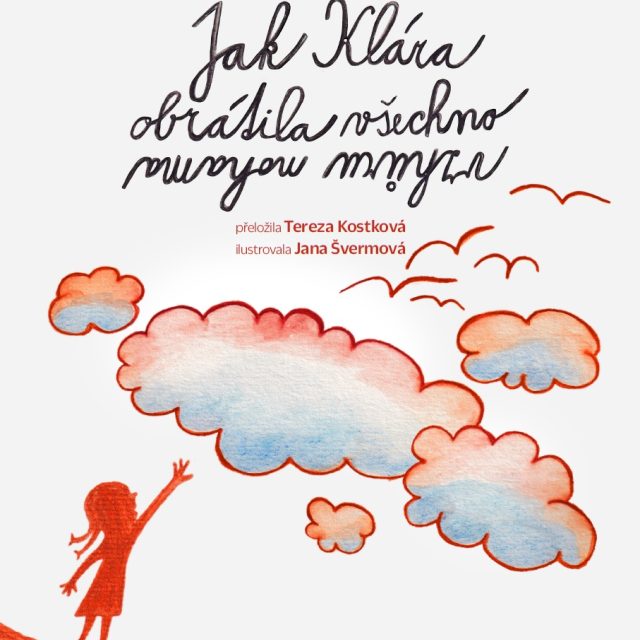

Kdo jste vy? Klára, nebo učitel?

Tereza Kostková, moderátorka ČRo Dvojka

Jak Klára obrátila všechno vzhůru nohama

Knížka režiséra a herce Jakuba Nvoty v překladu Terezy Kostkové předkládá malým i velkým čtenářům dialogy malé Kláry a učitele o světě, který se dá vnímat docela jinak, než jak se píše v učebnicích.